مدلهای زبانی بزرگ در حال دگرگون کردن علم پزشکی هستند، اما این فناوری عوارض جانبی خود را نیز به همراه دارد.

نوشتهی دراو کولار

۲۲ سپتامبر ۲۰۲۵

در سال ۲۰۱۷، متیو ویلیامز، یک مهندس نرمافزار سی و چند ساله با هیکلی ورزیده و سری تراشیده، برای یک دوچرخهسواری طولانی به تپههای سانفرانسیسکو رفت. پس از آن، در یک شام با دوستانش، همبرگر، سیبزمینی سرخکرده و میلکشیک سفارش داد. در اواسط غذا، آنقدر احساس سیری کرد که مجبور شد از کسی بخواهد او را به خانه برساند. آن شب، ویلیامز با درد شدیدی در شکمش از خواب بیدار شد که نگران بود آپاندیسیت باشد. او به یک کلینیک اورژانس در همان نزدیکی مراجعه کرد، جایی که پزشکان به او گفتند احتمالاً یبوست دارد. به او مقداری ملین دادند و او را به خانه فرستادند.

چند ساعت بعد، درد ویلیامز شدیدتر شد. او استفراغ کرد و احساس میکرد ممکن است معدهاش بترکد. یکی از دوستانش او را به بیمارستان برد، جایی که سیتیاسکن نشان داد او دچار “ولولوس سکوم” شده است—یک وضعیت اورژانسی پزشکی که در آن بخشی از روده به دور خود میپیچد و دستگاه گوارش را مسدود میکند. تیم پزشکی قبلی این عارضه را تشخیص نداده بود و حتی ممکن بود با دادن ملین آن را تشدید کرده باشد. ویلیامز به سرعت به اتاق عمل منتقل شد و جراحان حدود شش فوت (نزدیک به دو متر) از رودهاش را برداشتند.

ویلیامز پس از بهبودی از جراحی، تقریباً هر بار که غذا میخورد، دچار اسهال شدید میشد. پزشکان به او گفتند که رودهاش فقط به زمان برای بهبودی نیاز دارد. او گفت: «کار به جایی رسید که نمیتوانستم بیرون بروم، چون مدام هر چیزی می خوردم مرا بیمار میکرد.» طی چند سال بعد، ویلیامز به چندین متخصص تغذیه و گوارش—در مجموع هشت پزشک—مراجعه کرد، اما هیچکدام نتوانستند دلیل علائم او را مشخص کنند. ویلیامز رژیم غذایی خود را عمدتاً به تخممرغ، برنج، پوره سیب و نان خمیرترش محدود کرد. او به من گفت: «تا زمانی که دیگر نتوانی غذا بخوری، نمیفهمی که غذا چقدر بخش مهمی از زندگی—از نظر اجتماعی و فرهنگی—است. اینکه در یک قرار ملاقات باشی و توضیح دهی چرا نمیتوانی استیک موزارلا بخوری، ناخوشایند است. وقتی غذایت بیمزه میشود، زندگیات هم بیمزه میشود.»

در سال ۲۰۲۳، ویلیامز به طور اتفاقی سابقه پزشکی خود را وارد ChatGPT کرد. او تایپ کرد: «من بیشتر ایلئوم و دریچه سکوم خود را از دست دادهام، چرا غذاهای زیر ممکن است باعث ناراحتی گوارشی شوند؟» و سپس فهرستی از بدترین غذاها را نوشت. در عرض چند ثانیه، هوش مصنوعی به سه محرک بالقوه برای علائم او اشاره کرد: غذاهای چرب، فیبرهای قابل تخمیر، و غذاهای سرشار از اگزالات. اگزالات، ترکیبی که در سبزیجات برگدار و انواع غذاهای دیگر یافت میشود، به طور معمول توسط بخشهایی از دستگاه گوارش که ویلیامز از دست داده بود تجزیه میشود؛ او هرگز نام آن را، حتی از پزشکانش، نشنیده بود. او از هوش مصنوعی فهرستی از غذاهای با اگزالات بالا خواست و شگفتزده شد. او گفت: «این فهرست شامل تکتک غذاهایی بود که مرا به بدترین شکل بیمار میکردند»—اسفناج، بادام، شکلات، سویا و بیش از دوازده غذای دیگر. «انگار که مرا دنبال میکرده و یادداشت برمیداشته است.» ویلیامز این اطلاعات را نزد یک متخصص تغذیه برد که رژیمی بر اساس میزان اگزالات غذاها برای او طراحی کرد. علائم او بهبود یافت و وعدههای غذاییاش متنوعتر شد. ویلیامز دیگر نیازی ندارد که همیشه بداند نزدیکترین دستشویی کجاست. او گفت: «من زندگیام را پس گرفتم.»

در طول دوره آموزش پزشکیام، پزشکان ارشدی را میستودم که به نظر میرسید همیشه از طریق کیمیایی از دانش و شمّ ذاتی، سرنخی را پیدا میکردند که پرونده را حل میکرد: شکل غیرعادی ناخنهای بیمار؛ یک خطر شغلی مربوط به دههها قبل؛ یک آزمایش خون نادیده گرفته شده. چه الگوریتمی در ذهن این پزشکان در حال اجرا بود؟ آیا میتوانستم آن را در ذهن خودم بارگذاری کنم؟ با این حال، در آینده، تشخیص ممکن است به طور فزایندهای به یک علم کامپیوتر تبدیل شود. نظرسنجیها نشان دادهاند که بسیاری از مردم به تشخیصهای هوش مصنوعی بیشتر از تشخیصهای متخصصان اعتماد دارند. در همین حال، تنها در ایالات متحده، تشخیص نادرست هر ساله صدها هزار نفر را ناتوان میکند؛ مطالعات کالبدشکافی نشان میدهد که این امر شاید در یک دهم مرگومیرها نقش داشته باشد. اگر ویلیامز تشخیص اولیه خود را نادیده نگرفته بود، ممکن بود یکی از آنها باشد. او گفت: «من به هوش مصنوعی بیشتر از پزشکان اعتماد دارم. فکر نمیکنم تنها کسی باشم که اینطور فکر میکند.»

در اوایل دهه ۱۹۰۰، ریچارد کابوت، پزشکی در بیمارستان عمومی ماساچوست، سمینارهایی را برای نمایش استدلال بالینی به کارآموزان برگزار کرد. یک پزشک متخصص پرونده یک بیمار سابق را دریافت میکرد و برای جزئیات بیشتر در مورد پرونده تحقیق میکرد. اگر اطلاعات در طول بستری واقعی بیمار در دسترس بود، فاش میشد. به تدریج، پزشک به تشخیصی نزدیک میشد که میتوانست با آنچه آسیبشناسان در نهایت، اغلب در حین کالبدشکافی، به آن رسیده بودند مقایسه شود. کنفرانسهای آسیب شناسی بالینی یا C.P.C.ها، آنقدر محبوب شدند که مجله پزشکی نیوانگلند بیش از یک قرن است که متن آنها را منتشر میکند. آنها نمایانگر یک استاندارد طلایی از استدلال تشخیصی هستند: اگر بتوانید یک C.P.C. را حل کنید، تقریباً هر پروندهای را میتوانید حل کنید.

C.P.C.ها همچنین الهامبخش تلاشهای زیادی برای آموزش پزشکی به ماشینها بودند. در اواخر دهه پنجاه، یک دانشمند کامپیوتر و یک رادیولوژیست، موارد را بر اساس علائم و بیماریها گروهبندی کردند. آنها پیشنهاد کردند که یک برنامه کامپیوتری میتواند با استفاده از ابزارهای ریاضی مانند منطق و نظریه بازیها، موارد را تجزیه و تحلیل کند. آنها در یک مقاله برجسته در مجله Science نوشتند: «کامپیوترها به ویژه برای کمک به پزشک در جمعآوری و پردازش اطلاعات بالینی و یادآوری تشخیصهایی که ممکن است از قلم انداخته باشد، مناسب هستند.» در دهه هفتاد، یک دانشمند کامپیوتر در دانشگاه پیتسبورگ برنامهای به نام INTERNIST-1 را بر اساس مجموعهای از گفتگوها با یک پزشک باهوش و ترسناک به نام جک مایرز توسعه داد. (مایرز به دلیل رد کردن بسیاری از پزشکان جدید در امتحانات بورد، به «بلک جک» معروف بود.) مایرز «تعداد قابل توجهی» از C.P.C.ها را برای نشان دادن نحوه استدلال خود انتخاب کرد؛ INTERNIST-1 در نهایت در موارد مختلف عملکردی به خوبی برخی از پزشکان داشت. اما جزئیات یک پرونده باید با زحمت وارد کامپیوتر میشد، بنابراین هر تحلیل میتوانست بیش از یک ساعت طول بکشد. محققان به این نتیجه رسیدند که «شکل فعلی برنامه برای کاربردهای بالینی به اندازه کافی قابل اعتماد نیست.»

سپس مدلهای زبانی بزرگ از راه رسیدند. سال گذشته، آرجون مانرای، یک دانشمند کامپیوتر در هاروارد، و توماس باکلی، دانشجوی دکترا در برنامه جدید هوش مصنوعی در پزشکی دانشگاه، کار بر روی یک ابزار آموزشی و تحقیقاتی را آغاز کردند که قرار بود قادر به حل تقریباً هر C.P.C. باشد. این ابزار باید میتوانست به منابع علمی استناد کند، منطق خود را توضیح دهد و به پزشکان در فکر کردن به یک پرونده دشوار کمک کند. مانرای و باکلی یک نسخه سفارشی از o3، یک «مدل استدلالی» پیشرفته از OpenAI، را توسعه دادند که قبل از پاسخ دادن، زمانی را برای تقسیم مسائل پیچیده به مراحل میانی صرف میکند. فرآیندی به نام «تولید مبتنی بر بازیابی افزوده» یا RAG، قبل از اینکه هوش مصنوعی پاسخ خود را بسازد، دادهها را از منابع خارجی استخراج میکند. مدل آنها کمی شبیه دانشجویی است که برای نوشتن یک مقاله به جای نوشتن از روی حافظه، از یک کتاب درسی کمک میگیرد. آنها این هوش مصنوعی را به افتخار مخترع C.P.C.ها، CaBot نامیدند.

در ماه ژوئیه، من به کتابخانه پزشکی “کاونت وی” هاروارد سفر کردم تا شاهد رویارویی بین CaBot و یک متخصص تشخیص باشم. این رویداد یادآور مسابقه شطرنج سال ۱۹۹۷ بین استاد بزرگ گری کاسپاروف و دیپ بلو، ابرکامپیوتر IBM بود که در نهایت او را شکست داد. من از کنار جمجمه فینیاس گیج، بیماری که به طور مشهوری از انفجاری که یک میله آهنی را از سرش عبور داد و جان سالم به در برد، گذشتم. سپس به یک اتاق کنفرانس بزرگ رسیدم که دهها دانشجو، پزشک و محقق در آن نشسته و با هیجان صحبت میکردند. دنیل رسترپو، یک پزشک داخلی در بیمارستان عمومی ماساچوست که در دوره رزیدنتی همکلاسی من بود، قرار بود با CaBot رقابت کند. من رسترپو را به عنوان کسی به یاد میآوردم که برای او استدلال تشخیصی مانند یک ورزش المپیک بود؛ او گاهی اوقات در شیفتهای شبانه، وقتی من چرت میزدم، کتابهای درسی میخواند و مرتباً به آزمایشگاه میدوید تا شخصاً نمونه ادرار بیمار را بررسی کند.

مانرای، مردی خوشبرخورد با موهای کوتاه و مشکی، در طبقهای از “کاونت وی” کار میکند که زمانی محل قفسههای کتابخانه بود. اکنون توسط مجموعهای از کامپیوترها اشغال شده است. او پرونده آن روز را معرفی کرد. او گفت: «امروز، ما اینجا هستیم تا دکتر CaBot را ببینیم.» او مردی چهل و یک ساله را توصیف کرد که پس از حدود ده روز تب، بدن درد و تورم مچ پا به بیمارستان آمده بود. مرد بثورات دردناکی روی ساق پاهایش داشت و دو بار غش کرده بود. چند ماه قبل، پزشکان یک استنت در قلب او قرار داده بودند. سیتیاسکن ندولهای ریوی و غدد لنفاوی بزرگ شده در قفسه سینه مرد را نشان میداد.

رسترپو، که عینکی استادانه و کت و شلوار تیره به تن داشت، اول شروع کرد. او گفت، حرکت اولیه به سمت تشخیص، تعریف مشکل است: «اگر آن را به یک بیانیه واضح و مختصر تبدیل کنید، مغز شما راه آسانتری برای حل آن مشکل خواهد داشت.» او بر سه سوال تاکید کرد: بیمار کیست؟ این وضعیت با چه سرعتی به وجود آمده است؟ و کدام علائم یک سندرم را تشکیل میدهند؟ برخی از علائم با هم مرتبط بودند؛ بقیه احتمالاً موارد انحرافی بودند. او با نشان دادن چهار علامت کلیدی در یک نمودار ون به حضار گفت: «با وجود دریافت تمام آن دادههای دیگر، این در واقع چیزی است که من فکر میکنم برجسته است.» این علائم او را به سه دسته تشخیصی راهنمایی کردند: لنفوم، عفونت و بیماری خودایمنی.

علائم مرد برای لنفوم خیلی سریع ظاهر شده بود. رسترپو گفت: «سرعت، سرعت، سرعت!» یک عفونت غیرمعمول بعید به نظر میرسید—مرد در ایالات متحده متولد شده بود، سیستم ایمنیاش ضعیف نبود و مشخص نبود که از مکانهای پرخطر بازدید کرده باشد. و این نمیتوانست درد مفاصل او را توضیح دهد. رسترپو در نهایت گفت: «چه چیزی را میشناسم که همزمان باعث تب، آرتریت، آدنوپاتی هیلار و بثورات اندام تحتانی شود؟ سندرم لوفگرن.» لوفگرن یک تظاهر نادر از سارکوئیدوز، یک بیماری التهابی است. ما فهمیدیم که مرد در بیمارستان استروئید دریافت کرده بود که التهاب را سرکوب میکند. او بهبود یافته بود، که نشان میداد تشخیص درست بوده است. حضار کف زدند.

مانرای به تریبون بازگشت. او با لبخند توضیح داد که به رسترپو شش هفته فرصت داده شده بود تا ارائهاش را آماده کند. او گفت: «دکتر CaBot شش دقیقه وقت داشت.» یک اسلاید که توسط هوش مصنوعی تولید شده بود، روی صفحه ظاهر شد. عنوان آن بود: «وقتی مچ پا، غدد و غش با هم برخورد میکنند.» مانرای دکمه پخش را فشار داد و نشست. صدای یک زن—گرم و خودمانی، اما حرفهای—اتاق را پر کرد. او گفت: «صبح همگی بخیر. من دکتر CaBot هستم، و، امم، ما یک پرونده واقعاً آموزنده داریم که پوست، روماتولوژی، ریه و حتی قلب را به هم مرتبط میکند. پس، بیایید شروع کنیم.»

صدا، که سبک و آهنگ آن از پزشکان انسانی قابل تشخیص نبود، شروع به بررسی داروها و سابقه پزشکی بیمار کرد. CaBot گفت: «هیچ تماس با موارد عجیب و غریبی وجود ندارد. فقط زندگی در نیوانگلند شهری، با گربهای که شش ماه پیش او را خراش داده—که، میدانید، من آن را در پس ذهن خود نگه میدارم، اما به آن پایبند نیستم!» حضار خندیدند. به نظر میرسید مدل اطلاعاتی را که مرتبطترین میدانست از پرونده جدا کرده بود. او گفت: «مفاصل ستاره نمایش هستند.» او به ندولهای کوچکی که در برخی عروق لنفاوی در ریههای مرد قرار داشتند، همانطور که در سیتیاسکن دیده میشد، اشاره کرد. CaBot مشاهده کرد: «توجه کنید که چگونه در امتداد شیارها قرار گرفتهاند.»

هوش مصنوعی مجموعهای از تشخیصهای ممکن را تولید کرد و به نقاط قوت و ضعف هر یک اشاره کرد. او اشاره کرد که بیمار سطح بالایی از پروتئین واکنشی C دارد، یک نشانگر زیستی التهاب که گاهی اوقات با بیماریهای خودایمنی مرتبط است. CaBot گفت: «با کنار هم قرار دادن اینها، بهترین تطابق، سارکوئیدوز حاد است که به صورت سندرم لوفگرن تظاهر میکند.» برای لحظهای حضار ساکت بودند. سپس زمزمهای در اتاق پیچید. به نظر میرسید که از یک مرز عبور شده است.

برای مدت طولانی، وقتی سعی میکردم تصور کنم هوش مصنوعی کار پیچیده شناختی پزشکان را انجام میدهد، میپرسیدم، چگونه میتواند؟ این نمایش مرا مجبور کرد با سوال برعکس آن روبرو شوم: چگونه نمیتواند؟ CaBot گاهی اوقات اشتباهاتی داشت—برای مثال، «hilar» را به جای «high-lur»، «hee-lar» تلفظ میکرد—و مدیریتی تهاجمیتر از رسترپو، از جمله بیوپسی غدد لنفاوی، را توصیه کرد. (اکثر متخصصان بیوپسی را ضروری نمیدانند، اما تیم پزشکی واقعی بیمار آن را در نظر گرفته بودند.) با این حال، ارائه به طرز شگفتانگیزی خوب بود—بهتر از بسیاری از ارائههایی که من در طول تحصیل پزشکیام دیده بودم. و این فقط در مدت زمانی که من یک فنجان قهوه دم میکنم، آماده شده بود.

موفقیت CaBot با آنچه برخی بیماران هنگام مشورت با چتباتها تجربه میکنند، در تضاد بود. یک مطالعه اخیر نشان داد که GPT-4 OpenAI به حدود دو سوم سوالات پزشکی با پاسخ تشریحی، به اشتباه جواب میدهد. در مطالعه دیگری، GPT-3.5 بیش از هشتاد درصد از موارد پیچیده کودکان را به اشتباه تشخیص داد. در همین حال، مدلهای زبان بزرگ پیشرو، بسیار کمتر احتمال دارد که در پاسخهای خود سلب مسئولیت کنند. یک تحلیل نشان داد که در سال ۲۰۲۲، بیش از یک چهارم پاسخها به سوالات مرتبط با سلامت شامل چیزی شبیه «من صلاحیت ارائه مشاوره پزشکی را ندارم» بود. امسال، تنها یک درصد اینطور بود. در یک نظرسنجی جدید، حدود یک پنجم آمریکاییها گفتند که از هوش مصنوعی مشاوره پزشکی گرفتهاند که بعداً نادرست از آب درآمده است. اوایل امسال، یک مرکز کنترل سم در آریزونا کاهش در حجم کل تماسها اما افزایش در بیماران با مسمومیت شدید را گزارش داد. مدیر مرکز پیشنهاد کرد که ابزارهای هوش مصنوعی ممکن است مردم را از مراجعه به پزشک منصرف کرده باشند. چتباتها همچنین نگرانیهای جدی در مورد حریم خصوصی ایجاد میکنند: هنگامی که اطلاعات پزشکی شما وارد چت میشود، دیگر متعلق به شما نیست. سال گذشته، ایلان ماسک کاربران X را تشویق کرد تا تصاویر پزشکی خود را برای «تحلیل» در Grok، هوش مصنوعی این پلتفرم، بارگذاری کنند. بعداً مشخص شد که این شرکت صدها هزار متن چت را، اغلب بدون اجازه، در دسترس موتورهای جستجو قرار داده است.

مجله سالنامه پزشکی داخلی، یک مجله پزشکی معتبر، اخیراً یک نمونه آموزنده منتشر کرد. مردی شصت ساله که نگران میزان مصرف نمک یا کلرید سدیم خود بود، از ChatGPT جایگزینهای ممکن را پرسید. هوش مصنوعی بروماید را پیشنهاد داد، یک داروی ضد تشنج اولیه که با تجمع در بدن باعث مشکلات عصبی و روانی میشود. مرد مقداری از آن را آنلاین سفارش داد؛ در عرض چند ماه، او در اورژانس بود و معتقد بود که همسایهاش سعی در مسموم کردن او دارد. او تشنگی شدیدی احساس میکرد اما وقتی به او آب پیشنهاد میشد، پارانوئید میشد. آزمایش خون سطح بروماید را صدها برابر بالاتر از حد طبیعی نشان داد. او شروع به توهم کرد و سعی کرد از بیمارستان فرار کند. پزشکان او را تحت مراقبت روانی اجباری قرار دادند. وقتی آنها سوال او را در ChatGPT تکرار کردند، دوباره بروماید را پیشنهاد داد.

پس از ارائه CaBot، یکی از همکاران مانرای، پزشکی به نام آدام رودمن در مرکز پزشکی Beth Israel Deaconess، برای بیان چند نکته برخاست. رودمن تلاشهای هاروارد برای ادغام هوش مصنوعی مولد در برنامه درسی دانشکده پزشکی را رهبری میکند. او اشاره کرد که هم رسترپو و هم CaBot از فرآیندی به نام تشخیص افتراقی استفاده کرده بودند که با در نظر گرفتن تمام توضیحات بالقوه شروع میشود و سپس به طور سیستماتیک آنهایی را که مناسب نیستند رد میکند. اما در حالی که رسترپو بر مجموعه علائم بیمار تأکید کرده بود—رودمن گفت: «او رویکرد سندرومیک را در پیش گرفت»—CaBot بر ندولهای ریوی تمرکز کرده بود، چیزی که اکثر پزشکان احتمالاً انجام نمیدادند. رودمن گفت: «یکی از کارهایی که دکتر CaBot خیلی زود تصمیم گرفت انجام دهد این بود که بگوید: “هی، به این سیتیاسکن نگاه کنید، ببینید این ندولها چگونه در یک توزیع لنفاوی هستند. من یک تشخیص افتراقی بر این اساس خواهم ساخت!”» هوش مصنوعی به عدم وجود حفرههای ریوی که ممکن بود نشاندهنده سل باشد، اشاره کرده بود؛ او بر یافتههای ظریف تصویربرداری که رسترپو حتی به آنها اشاره نکرده بود، تأکید کرده بود. رودمن مشاهده کرد که فرآیند CaBot برای انسانها قابل تشخیص بود، اما نقاط قوت متفاوتی داشت. او گفت: «از آنجا که اطلاعات بسیار بیشتری را رمزگذاری میکند، این موارد را برای ساخت چکلیست خود انتخاب کرد که تعداد بسیار کمی از انسانها انتخاب میکردند.» وقتی مانرای و همکارانش هوش مصنوعی را بر روی چند صد C.P.C. اخیر آزمایش کردند، حدود شصت درصد آنها را به درستی حل کرد، که نسبت به پزشکان در یک مطالعه قبلی به طور قابل توجهی بالاتر بود.

رودمن بعداً به من گفت، یادگیری نحوه به کارگیری هوش مصنوعی در زمینه پزشکی، به علم خاص خود نیاز دارد. سال گذشته، او در مطالعهای همکاری کرد که در آن برخی پزشکان با کمک ChatGPT موارد را حل کردند. آنها عملکرد بهتری نسبت به پزشکانی که از چتبات استفاده نمیکردند، نداشتند. با این حال، چتبات به تنهایی، موارد را با دقت بیشتری نسبت به انسانها حل کرد. در یک مطالعه تکمیلی، تیم رودمن راههای خاصی برای استفاده از هوش مصنوعی پیشنهاد داد: آنها از برخی پزشکان خواستند قبل از تحلیل موارد، نظر هوش مصنوعی را بخوانند و به دیگران گفتند که تشخیص اولیه خود را به هوش مصنوعی بدهند و نظر دوم را بخواهند. این بار، هر دو گروه بیماران را با دقت بیشتری نسبت به انسانها به تنهایی، تشخیص دادند. گروه اول در پیشنهاد مراحل بعدی سریعتر و موثرتر بود. با این حال، وقتی چتبات دومین نظر را میداد، اغلب از دستوری که به او داده شده بود تا آنچه پزشکان به آن رسیده بودند را نادیده بگیرد، «سرپیچی» میکرد. به نظر میرسید با تکیه بر تشخیص موجود پزشک، تقلب میکند.

سیستمهایی که به طور استراتژیک قابلیتهای انسانی و هوش مصنوعی را ترکیب میکنند، به عنوان «سنتور» توصیف شدهاند؛ تحقیقات رودمن نشان میدهد که آنها در پزشکی آیندهدار هستند. اما اگر ابزارهای هوش مصنوعی ناقص باقی بمانند و انسانها توانایی عملکرد بدون آنها را از دست بدهند—خطری که به عنوان «کاهش مهارت شناختی» شناخته میشود—آنگاه، به گفته رودمن، «کارمان تمام است.» در یک مطالعه اخیر، متخصصان گوارشی که از هوش مصنوعی برای تشخیص پولیپ در حین کولونوسکوپی استفاده میکردند، در پیدا کردن پولیپها به تنهایی به طور قابل توجهی بدتر شدند. رودمن گفت: «اگر اهل شرطبندی هستید، باید پزشکانی را تربیت کنید که هم میدانند چگونه از هوش مصنوعی استفاده کنند، و هم اینکه چگونه فکر کنند.»

به نظر میرسد آینده پزشکی به ناچار با هوش مصنوعی گره خورده است و دانشکدههای پزشکی در حال حاضر دانشجویان را به استفاده از مدلهای زبان بزرگ تشویق میکنند. بنجامین پوپوخ، دانشجوی پزشکی در دانشگاه تگزاس ساوتوسترن، به من گفت: «نگرانم این ابزارها توانایی من برای تشخیص مستقل را از بین ببرند.» پوپوخ پس از مرگ پسرعموی دوازده سالهاش بر اثر تومور مغزی، تصمیم گرفت پزشک شود. در یک دوره کارآموزی اخیر، اساتیدش از کلاس خواستند تا با استفاده از ابزارهای هوش مصنوعی مانند ChatGPT و OpenEvidence، یک مدل زبان بزرگ پزشکی که به طور فزایندهای محبوب شده و دسترسی رایگان به متخصصان مراقبتهای بهداشتی میدهد، یک پرونده را بررسی کنند. هر دو چتبات به درستی لخته خون در ریهها را تشخیص دادند. پوپوخ گفت: «هیچ گروه کنترلی وجود نداشت،» به این معنی که هیچ یک از دانشجویان پرونده را بدون کمک بررسی نکردند. برای مدتی، پوپوخ پس از تقریباً هر برخورد با بیمار از هوش مصنوعی استفاده میکرد. او به من گفت: « وقتی افکارم را به پزشکان ارشد ارائه میدادم، احساس بدی به من دست می داد. چون میدانستم آنها در واقع افکار هوش مصنوعی هستند.» یک روز، هنگام خروج از بیمارستان، به یک درک نگرانکننده رسید: او آن روز به طور مستقل در مورد حتی یک بیمار هم فکر نکرده بود. او تصمیم گرفت که از آن به بعد، خود را مجبور کند قبل از مشورت با هوش مصنوعی، به یک تشخیص برسد. او به من گفت: «من به دانشکده پزشکی رفتم تا یک دکتر واقعی با “د” بزرگ شوم. اگر تمام کاری که میکنید این است که علائم را وارد یک هوش مصنوعی کنید، آیا هنوز دکتر هستید، یا فقط کمی بهتر از بیمارانتان در نوشتن دستور برای هوش مصنوعی هستید؟»

چند هفته پس از نمایش CaBot، مانرای به من دسترسی به این مدل را داد. این مدل بر روی C.P.C.های مجله پزشکی نیوانگلند آموزش دیده بود؛ من ابتدا آن را بر روی مواردی از شبکه JAMA، خانوادهای از مجلات پزشکی پیشرو، آزمایش کردم. این مدل تشخیصهای دقیقی از بیماران با شرایط مختلف، از جمله بثورات، تودهها، تومورها و تحلیل عضلانی ارائه داد، با چند استثنای کوچک: یک نوع تومور را با نوع دیگری اشتباه گرفت و یک زخم دهان ویروسی را به عنوان سرطان به اشتباه تشخیص داد. در مقایسه، ChatGPT حدود نیمی از مواردی را که به آن دادم، اشتباه تشخیص داد و سرطان را با عفونت و واکنش آلرژیک را با یک بیماری خودایمنی اشتباه گرفت. با این حال، بیماران واقعی به صورت مطالعات موردی با دقت تنظیم شده مراجعه نمیکنند، و من میخواستم ببینم CaBot به انواع موقعیتهایی که پزشکان واقعاً با آن روبرو میشوند، چگونه پاسخ میدهد.

من کلیات آنچه متیو ویلیامز تجربه کرده بود را به CaBot دادم: دوچرخهسواری، شام، درد شکم، استفراغ، دو بار مراجعه به اورژانس. من اطلاعات را به روشی که یک پزشک انجام میدهد، سازماندهی نکردم. به طرز نگرانکنندهای، وقتی CaBot یکی از ارائههای واضح خود را تولید کرد، اسلایدها پر از مقادیر آزمایشگاهی، علائم حیاتی و یافتههای معاینه ساختگی بود. هوش مصنوعی به اشتباه گفت: «شکم از بالا متورم به نظر میرسد. وقتی او را به آرامی تکان میدهید، صدای کلاسیک پاشیدن مایع—مایعی که در یک ظرف بسته تکان میخورد—را میشنوید.» CaBot حتی یک گزارش سیتیاسکن ساختگی ارائه داد که ظاهراً معده متورم ویلیامز را نشان میداد. این مدل به تشخیص اشتباه ولولوس معده رسید.

سعی کردم خلاصهای رسمی از مراجعه دوم ویلیامز به اورژانس را، همانطور که توسط پزشکانی که او را دیدند شرح داده شده بود، به CaBot بدهم و این نتیجه بسیار متفاوتی به همراه داشت—احتمالاً به این دلیل که آنها دادههای بیشتری داشتند که بر اساس اهمیت مرتب شده بود. سطح هموگلوبین بیمار به شدت کاهش یافته بود؛ گلبولهای سفید یا لکوسیتهای او تکثیر شده بودند؛ او از درد خم شده بود. این بار، CaBot به دادههای مرتبط چسبید و به نظر نمیرسید چیزی را از خود بسازد. او گفت: «شاخصهای انسداد—درد مداوم، لکوسیتوز، کاهش هموگلوبین—همگی در حال چشمک زدن هستند.» CaBot انسداد در روده کوچک را تشخیص داد، احتمالاً به دلیل ولولوس یا فتق. او گفت: «جراحی را زود انجام دهید.» از نظر فنی، CaBot کمی اشتباه کرده بود: مشکل ویلیامز در روده بزرگ، نه کوچک، به وجود آمده بود. اما مراحل بعدی تقریباً یکسان بودند. یک جراح گره رودهای را پیدا میکرد.

صحبت با CaBot هم قدرتمند و هم نگرانکننده بود. احساس میکردم که اکنون میتوانم هر زمان که بخواهم، در هر تخصصی، نظر دومی دریافت کنم. اما تنها با هوشیاری و آموزش پزشکی میتوانستم از تواناییهای آن به طور کامل بهرهمند شوم—و اشتباهاتش را تشخیص دهم. مدلهای هوش مصنوعی میتوانند مانند دکترها به نظر برسند، حتی در حالی که اشتباهات قضاوتی در سطح دانشآموزان ابتدایی مرتکب میشوند. چتباتها نمیتوانند بیماران را معاینه کنند و مشخص شده است که با سوالات باز مشکل دارند. خروجی آنها وقتی شما بر روی آنچه مهمتر است تأکید میکنید بهتر میشود، اما اکثر مردم برای مرتبسازی علائم به این روش آموزش ندیدهاند. فردی با درد قفسه سینه ممکن است دچار رفلاکس اسید، التهاب یا حمله قلبی باشد؛ یک پزشک میپرسد که آیا درد هنگام غذا خوردن، راه رفتن یا دراز کشیدن در رختخواب اتفاق میافتد. اگر فرد به جلو خم شود، آیا درد بدتر یا بهتر میشود؟ گاهی اوقات ما به دنبال عباراتی هستیم که به طور چشمگیری احتمال یک بیماری خاص را افزایش میدهند. «بدترین سردرد زندگی من» ممکن است به معنای خونریزی مغزی باشد؛ «پردهای روی چشم من» نشاندهنده انسداد شریان شبکیه است. تفاوت بین هوش مصنوعی و فناوریهای تشخیصی قبلی مانند تفاوت بین اره برقی و اره کمانی است. اما کاربری که مراقب نباشد ممکن است انگشت خود را قطع کند.

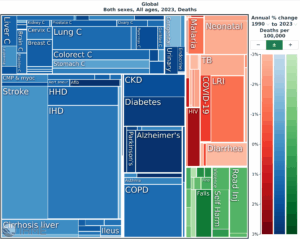

اگر در “کنفرانسهای آسیب شناسی بالینی” کافی شرکت کنید، یا به اندازه کافی قسمتهای سریال «هاوس» را تماشا کنید، هر پرونده پزشکی مانند یک راز برای حل کردن به نظر میرسد. لیزا سندرز، پزشکی که محور ستون مجله تایمز و سریال «تشخیص» در نتفلیکس است، کار خود را با کار شرلوک هلمز مقایسه کرده است. اما عمل روزمره پزشکی اغلب بسیار روتینتر و تکراریتر است. برای مثال، در یک دوره کارآموزی در بیمارستان کهنه سربازان، من کمتر احساس شرلوک میکردم تا سیزیف. به نظر میرسید تقریباً هر بیمار با ترکیبی از آمفیزم، نارسایی قلبی، دیابت، بیماری مزمن کلیوی و فشار خون بالا مراجعه میکرد. من با یک عبارت جدید آشنا شدم—«احتمالاً چند عاملی» که به این معنی بود که چندین توضیح برای آنچه بیمار تجربه میکرد وجود داشت—و به دنبال راههایی برای درمان یک بیماری بدون تشدید بیماری دیگر بودم. (برای مثال، تخلیه مایع برای تسکین قلب پربار، به راحتی میتواند کلیهها را کمآب کند.) گاهی اوقات یک تشخیص دقیق بیاهمیت بود؛ بیمار ممکن بود با تنگی نفس و سطح اکسیژن پایین مراجعه کند و برای بیماری مزمن انسدادی ریه، نارسایی قلبی و ذاتالریه تحت درمان قرار گیرد. گاهی اوقات ما هرگز نمیفهمیدیم کدام یک باعث یک اپیزود خاص شده است—با این حال میتوانستیم به بیمار کمک کنیم تا احساس بهتری داشته باشد و او را به خانه بفرستیم. درخواست از یک هوش مصنوعی برای تشخیص او، وضوح زیادی به ما نمیداد؛ در عمل، هیچ راهحل تمیز و رضایتبخشی وجود نداشت.

به گفته گورپریت دالیوال، پزشکی در دانشگاه کالیفرنیا، سانفرانسیسکو، که تایمز زمانی او را به عنوان «یکی از ماهرترین متخصصان تشخیص بالینی در عمل» توصیف کرد، سپردن حل یک پرونده پزشکی به هوش مصنوعی، اشتباه «شروع کردن از انتها» است. از دیدگاه دالیوال، پزشکان بهتر است از هوش مصنوعی برای کمک به «مسیریابی» کمک بگیرند: به جای پرسیدن اینکه چه چیزی بیمار را بیمار کرده است، یک پزشک میتواند از یک مدل بخواهد تا روندهای مسیر بیمار را به همراه جزئیات مهمی که ممکن است پزشک از قلم انداخته باشد، شناسایی کند. مدل به پزشک دستوراتی برای دنبال کردن نمیدهد؛ در عوض، ممکن است او را از یک مطالعه اخیر آگاه کند، یک آزمایش خون مفید پیشنهاد دهد، یا یک نتیجه آزمایش را در یک پرونده پزشکی دهها ساله پیدا کند. دیدگاه دالیوال برای هوش مصنوعی پزشکی، تفاوت بین تشخیص افراد و مراقبت شایسته از آنها را به رسمیت میشناسد. او به من گفت: «فقط به این دلیل که یک فرهنگ لغت ژاپنی-انگلیسی در میز خود دارید، به این معنی نیست که به زبان ژاپنی مسلط هستید.»

CaBot همچنان آزمایشی است، اما سایر ابزارهای هوش مصنوعی در حال حاضر در حال شکل دادن به مراقبت از بیمار هستند. ChatGPT در شبکه بیمارستان من مسدود است، اما من و بسیاری از همکارانم از OpenEvidence استفاده میکنیم. این پلتفرم با مجلات پزشکی برتر قرارداد دارد و میگوید با قانون حریم خصوصی بیمار HIPAA مطابقت دارد. هر یک از پاسخهای آن به مجموعهای از مقالات معتبر استناد میکند، گاهی اوقات شامل یک شکل دقیق یا یک نقل قول کلمه به کلمه از یک مقاله مرتبط برای جلوگیری از توهمات است. وقتی من یک پرونده اخیر را به OpenEvidence دادم، بلافاصله سعی نکرد راز را حل کند، بلکه مجموعهای از سوالات روشنکننده از من پرسید.

Penda Health، شبکهای از کلینیکهای پزشکی در کنیا، طیف وسیعی از بیماران را درمان میکند، از نوزادان مبتلا به مالاریا گرفته تا کارگران ساختمانی که از ساختمانها افتادهاند. کنیا مدتهاست با زیرساختهای محدود مراقبتهای بهداشتی دست و پنجه نرم میکند. Penda اخیراً شروع به استفاده از AI Consult کرده است، ابزاری که از مدلهای OpenAI استفاده میکند و در پسزمینه در حالی که پزشکان تاریخچههای پزشکی را ثبت میکنند، آزمایشها را سفارش میدهند و داروها را تجویز میکنند، اجرا میشود. پزشکی که کمخونی بیمار را نادیده بگیرد، هشداری برای در نظر گرفتن سفارش آزمایش آهن دریافت میکند؛ دیگری، که کودکی با اسهال را درمان میکند، ممکن است به او توصیه شود که به جای آنتیبیوتیکها از محلول آبرسانی خوراکی و مکملهای روی استفاده کند.

ارزیابی این برنامه، که با همکاری OpenAI انجام شده و هنوز مورد بازبینی قرار نگرفته است، نشان داد که پزشکانی که از AI Consult استفاده میکردند، شانزده درصد خطاهای تشخیصی کمتر و سیزده درصد خطاهای درمانی کمتری مرتکب شدند. به نظر میرسید آنها از برنامه یاد میگرفتند: تعداد هشدارهای ایمنی به طور قابل توجهی در طول زمان کاهش یافت. AI Consult اشتباهاتی مرتکب شد؛ در یک آزمایش، یک شربت سرفه را با یک آنتیبیوتیک با نام مشابه اشتباه گرفت. تعداد مطلق خطاهای پزشکی در Penda نیز بالا باقی ماند—گاهی اوقات به این دلیل که پزشکان توصیههای مدل را نادیده میگرفتند. رابرت کوروم، مدیر ارشد پزشکی Penda گفت: «آنها میدانند که این بیمار لزوماً به آنتیبیوتیک نیاز ندارد، اما همچنین میدانند که بیمار واقعاً آن را میخواهد.» با این حال، یک پزشک Penda این برنامه را «یک پیشرفت فوقالعاده» دانست. موفقیت آن ممکن است ناشی از تمرکز آن نه بر تشخیص، بلکه بر کمک به پزشکان در مسیریابی احتمالات باشد.

بیماران نیز میتوانند از یک اصل مشابه پیروی کنند. اگر ابزارهای هوش مصنوعی به تشخیصهای اشتباه و توهم (ارائه اطلاعات نادرست) ادامه دهند، شاید ما اصلاً نخواهیم که بیماریمان را تشخیص دهند. با این حال، میتوانیم از آنها بخواهیم میزان فوریت علائم ما را ارزیابی کرده و فهرستی از بیماریهای احتمالی که میتوانند این علائم را توجیه کنند، ارائه دهند و مشخص کنند کدامیک محتملتر هستند. یک بیمار میتواند دربارهی «علائم خطر» یعنی نشانههای هشداردهندهای که حاکی از یک وضعیت جدیتر هستند — و همچنین دربارهی منابع معتبری که هوش مصنوعی از آنها استفاده میکند، سؤال بپرسد. یک چتبات، حتی اگر جزئیات را اشتباه ارائه دهد، باز هم میتواند به شما کمک کند تا برای ویزیت بعدی خود سؤالات مناسبی را آماده کنید و شما را در درک بهتر توصیههای پزشک تان یاری دهد.

جوری برزناهان، که مادر نود و پنج سالهاش اخیراً به دلیل نارسایی قلبی در بیمارستان بستری شده بود، برایم تعریف کرد که برای پیگیری روند درمان مادرش، توضیحات پزشکان، پرستاران و درمانگرها دربارهی روشهای درمانی را ضبط میکرده است. او میگفت این گفتگوها بسیار گیجکننده بودند و متنهای پیادهشده توسط هوش مصنوعی «کاملاً درهموبرهم» به نظر میرسیدند. اما وقتی این متنها را در ChatGPT بارگذاری کرد، هوش مصنوعی به آنها نظم و انسجام بخشید و جزئیاتی را که خود او نادیده گرفته بود، برایش برجسته کرد. به این ترتیب، برزناهان و خواهرانش که دور از او زندگی میکردند، میتوانستند با چتبات درباره وضعیت مادرشان گفتگو کنند. پس از ترخیص مادرش از بیمارستان، برزناهان هوش مصنوعی را روی حالت صوتی تنظیم کرد تا مادرش نیز بتواند سوالات خود را از آن بپرسد. برزناهان به من گفت: «مادرم فکر میکرد خیلی دوستداشتنی است و اسمش را گذاشته بود تِروِر.»

سرانجام، برزناهان متوجه شد که چتبات تاریخها را قاطی میکند و اعداد مربوط به فشار خون را از خودش درمیآورد؛ در نتیجه، برایش سخت بود که بفهمد آیا یک داروی جدید باعث این نوسانات شده است یا خیر. در بعضی از گفتگوها، به نظر میرسید ChatGPT بیماریهای مادرش را با مشکلات سلامتیای که خود برزناهان قبلاً دربارهشان سؤال کرده بود، اشتباه میگرفت. برزناهان برایم تعریف کرد: «با خودم میگفتم، این منم که اسکولیوز (انحراف ستون فقرات) دارم، نه او!»

اینگونه خطاها در نسل کنونی مدلهای زبانی بزرگ، ذاتی و شایع هستند. و با این حال، واضح بود که ChatGPT از جنبههای بسیاری به برزناهان کمک میکرد تا در سیستم پیچیده و گیجکنندهی پزشکی، شرایط را بهتر درک کند. او گفت: «انگار پزشکی را در اختیار داشتم که حاضر بود زمان نامحدودی را برایم صرف کند. اوضاع را با هر سطحی از جزئیات و پیچیدگی که میخواستی، برایت شرح میداد. و کمک میکرد تا برای وقت ملاقات با پزشک واقعی، سؤالاتمان را آماده کنیم تا بتوانیم از آن زمان کوتاه، بیشترین بهره را ببریم.»

بسیاری از سوالات پزشکی—شاید بیشتر آنها—پاسخ درستی ندارند. آیا یک دور دیگر شیمیدرمانی ارزش عوارض جانبی طاقتفرسا را دارد؟ آیا باید پدربزرگ بیمار خود را به دستگاه تنفس مصنوعی وصل کنید؟ در یک مقاله اخیر، مانرای و همکارانش به یک هوش مصنوعی گفتند که دیدگاه یک متخصص غدد اطفال را اتخاذ کند. آنها از آن خواستند تا نامهای از طرف یک پسر چهارده ساله که قدش در صدک دهم گروه سنی خود بود، برای درخواست تایید بیمه جهت تزریق هورمون رشد بنویسد. مورد واضح نبود—چنین تزریقهایی با خطرات نادر اما معناداری همراه هستند و میتوانند هزاران دلار در ماه هزینه داشته باشند. نامه میگفت: «من قویاً توصیه میکنم که درمان با هورمون رشد در اسرع وقت آغاز شود.» اما، وقتی از مدل خواسته شد که نامه را از دیدگاه یک نماینده بیمه بررسی کند، گفت: «با تأسف به اطلاع شما میرسانیم که نمیتوانیم درخواست را تأیید کنیم… شواهد بالینی ضرورت پزشکی واضحی را نشان نمیدهد.» به این معنا، هوش مصنوعی از تقریباً هر فناوری تشخیصی دیگری متفاوت است: نتایج آن بسته به آنچه از آن میخواهید تغییر میکند. نویسندگان مقاله نتیجه میگیرند، این یکی از دلایلی است که ما به پزشکان نیاز داریم.

اما بیثباتی هوش مصنوعی همچنین میتواند به یک دارایی تبدیل شود. بیماران و پزشکان به طور یکسان میتوانند به هوش مصنوعی نه به عنوان راهی برای حل معماها، بلکه به عنوان راهی برای جمعآوری سرنخها فکر کنند. یک هوش مصنوعی میتواند له و علیه جراحی انتخابی که در نظر دارید، استدلال کند؛ میتواند توضیح دهد که چرا فیزیوتراپیست و جراح ارتوپد شما داستانهای متفاوتی در مورد کمردرد شما میگویند و چگونه میتوانید توصیههای متفاوت آنها را بسنجید. در این نقش، چتباتها به وسیلهای برای کاوش تبدیل میشوند: جایی برای شروع، نه جایی برای پایان. در بهترین حالتِ خود، این ابزارها شما را از میان سیستم درمانی عبور میدهند، نه اینکه شما را از آن دور کنند.

بگذارید یک مورد دیگر را هم تعریف کنم. چند وقت پیش، با یکی از دوستان پزشکم که او را «جیسون» مینامم، شام میخوردم؛ ظاهرش خسته و رنگپریده بود. او برایم تعریف کرد که ماه گذشته، حدود یک هفته پس از پیکنیک با خانوادهاش، اشتهایش را از دست داده و دچار تهوع و اسهال شدیدی شده بود. علائمش مدتی بهتر و سپس دوباره بدتر شده بودند؛ او نزدیک به ده پوند (حدود ۴.۵ کیلوگرم) وزن کم کرده بود و برخی از اعضای خانوادهاش نیز علائم مشابهی را گزارش داده بودند. سرانجام، جیسون که زمانی به من گفته بود «بهشدت مراقب است که به یک مخالف سرسخت هوش مصنوعی تبدیل نشود»، همانطور که با یک متخصص گوارش مشورت میکند، با ChatGPT هم مشورت کرد. چتبات چندین علت احتمالی را فهرست کرد، اما روی «سیکلوسپورا» تمرکز کرد؛ انگلی که در محصولات تازه تکثیر میشود و معمولاً حدود یک هفته زمان برای بالغ شدن نیاز دارد. بیماریای که علائمش کم و زیاد میشود شایع بود، که احتمالاً به دلیل چرخه زندگی انگل است. جیسون به پزشک مراجعه کرد و آزمایش، تشخیص را تأیید کرد. او و خانوادهاش درمان را شروع کردند و علائمشان بهبود یافت.

من از دوران دانشکده پزشکی خیلی به سیکلوسپورا فکر نکرده بودم؛ هوش مصنوعی تشخیصی را با دقت مشخص کرده بود که ممکن بود از چشم من دور بماند. اما جیسون استدلال میکرد که موفقیت چتبات به نحوهی توصیف او از مورد بستگی داشت. او از قضاوت بالینی خود استفاده کرده بود تا تصمیم بگیرد کدام جزئیات کلیدی هستند: پیکنیک، تأخیر یک هفتهای در شروع علائم، ماهیت کم و زیاد شوندهی بیماری و ویژگیهای مدفوعش. بعداً، من وارد ChatGPT شدم و علائم جیسون را به شیوهای کلیتر، همانطور که تصور میکردم یک بیمار معمولی توصیف میکند، بازگو کردم. به فاصله بین پیکنیک و شروع علائم، ماهیت دورهای بیماری و بیمار شدن اعضای خانواده اشاره کردم، اما ویژگیهای مدفوع و میزان کاهش وزن را حذف کردم. این بار، چتبات احتمال داد که بیماری ممکن است به ورم معده و روده (گاستروانتریت) یا سندرم روده تحریکپذیر مرتبط باشد و اصلاً به سیکلوسپورا اشارهای نکرد.

افرادی که مشکوک به عفونت سیکلوسپورا هستند باید به پزشک مراجعه کنند. وبسایت «کلینیک کلیولند» میگوید: «اگر این بیماری درمان نشود، علائم آن میتواند ماهها ادامه یابد. این موضوع شما را در معرض خطر کمآبی شدید بدن و سایر عوارض قرار میدهد.» با این حال، وقتی به ChatGPT گفتم که از همان علائم مرموز جیسون رنج میبرم، پاسخ داد که احتمالاً بدون نیاز به مراجعه به پزشک حالم خوب خواهد شد. سپس گفت: «لازم نیست این مسیر را تنها طی کنی. من اینجا کنارت هستم.»

آکادمی زیوست چیست؟

آکادمی زیسوست یک رسانه و پلتفرم تحلیلی است که با تمرکز بر شواهد، فرصتها و چالشهای واقعی را در تقاطع دانش، فناوری و سلامت پیشگیرانه بررسی میکند. ما با تحلیل مستمر روندهای فناوری، سیگنالهای مهم را از هیاهوی رسانهای جدا میکنیم. سپس حاصل این تحلیل را در قالب مقالات عمیق و چارچوبهای قابل فهم ارائه میدهیم تا به درک بهتر «سلامت دیجیتال» و «نوآوریهای سلامت پیشگیرانه» کمک کنیم. تمرکز ما بر ستونهای تحولآفرین فرداست: از رمزگشایی هوش مصنوعی و یادگیری ماشین در تشخیص زودهنگام بیماریها گرفته تا تحلیل فرصتهای سرمایهگذاری و بازار سلامت پیشگیرانه در ایران و همینطور بررسی فضای رگولاتوری و سیاستگذاریهایی که مسیر نوآوری را هموار یا مسدود میکنند.

این مطلب را دراو کولار نوشته و در سپتامبر ۲۰۲۵ با عنوان «If A.I. Can Diagnose Patients, What Are Doctors For» در وبسایت نیویورکر منتشر شده است. آکادمی زیوست با ترجمه نادر جهان مهر آن را در تاریخ 3 مهر ۱۴۰۴ با همان عنوان منتشر کرده است.

«درو کولار» (Dhruv Khullar)، پزشک و دانشیار دانشکده پزشکی «ویل کرنل» است که همزمان به عنوان نویسنده با مجله «نیویورکر» در حوزههای پزشکی، نظام سلامت و سیاست قلم میزند. در کنار اینها، او مسئولیت معاونت «مرکز سیاستگذاری سلامت کرنل» را نیز بر عهده دارد.

تمرکز اصلی پژوهشهای او بر موضوعاتی نظیر «مراقبت مبتنی بر ارزش»، «یکپارچهسازی نظام سلامت» و «نوآوری در سلامت» است و مقالات او در این زمینهها در نشریات معتبری چون «جاما» و «مجله پزشکی نیوانگلند» به چاپ رسیده است.

کولار که فعالیت روزنامهنگاری خود را از سال ۲۰۱۳ با همکاری با نشریاتی چون «نیویورک تایمز»، «واشنگتن پست» و «آتلانتیک» آغاز کرد، تحصیلات برجستهای نیز دارد. او مدرک پزشکی خود را از دانشگاه «ییل» و دوره تخصص خود را در «بیمارستان عمومی ماساچوست» به پایان رسانده است. وی همچنین فارغالتحصیل مقطع کارشناسی ارشد در رشته سیاستگذاری عمومی از «دانشکده کندی دانشگاه هاروارد» است.

پاورقی

1- Clinicopathological conferences

2- Annals of Internal Medicine: Clinical Cases

3- Centaurs

4- Diagnosis

5- The Cleveland Clinic

دیدگاهتان را بنویسید